PC360

Ремонт/настройка ПК и окружающих его устройств.

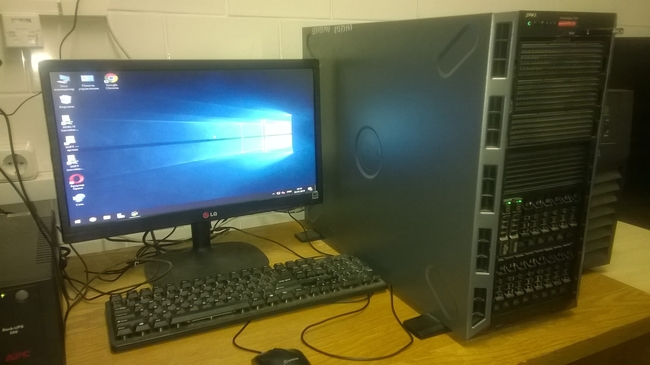

Сервер Dell PowerEdge T430 – подключение, настройка, установка ОС.

Небольшая предыстория рассказывает о том, что изначально в нашей организации на сервере Dell PowerEdge T430 был установлен Linux Oracle 7.3 и в нем виртуальные машины с ОС Windows Server.

Однако, такая схема периодически давала сбой. С учетом того, что одной из виртуальных машин был сервер МАП и 127 его пользователей в сети, перезагружать сервер было не очень приятно, все начинали жаловаться и шуметь. Наконец, было принято решение демонтировать виртуальные машины, удалить Линукс и настроить сервер МАП на физической машине на Windows Server 2019. Чтоб не останавливать рабочий процесс в организации, где вся работа завязана на МАПе, был смонтирован и настроен резервный сервер МАП, на него были перенесены настройки, база данных, службы и он работал в течение нескольких дней, пока происходила настройка основного сервера. О том, как происходила настройка главного сервера Dell PowerEdge T430 написано далее.

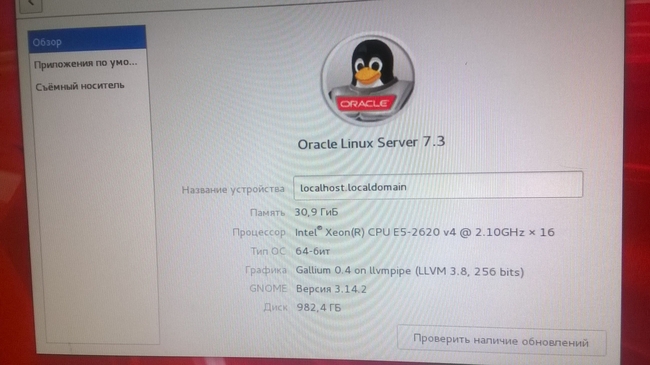

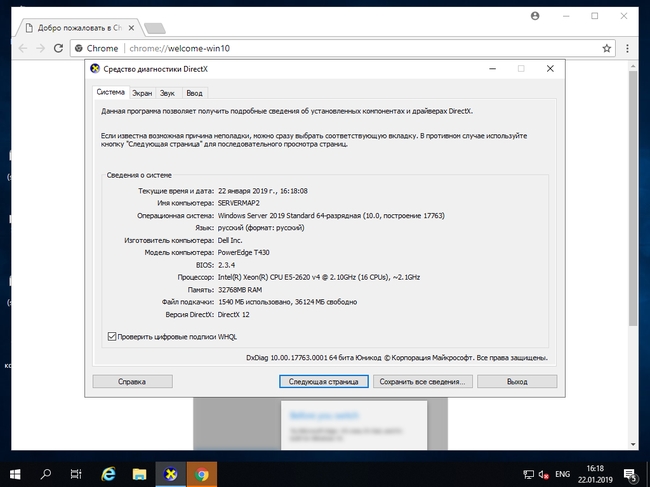

В нашей конфигурации сервер обладает следующими параметрами:

Материнская плата: Dell Inc. 0KX11M

Процессор: Intel Xeon E5-2620 v4 2.1GHz (8 ядер, 16 потоков)

ОЗУ: 32Гб DDR4 (DUAL IN-LINE MEMORY MODULE, 16GB, 2400, 2RX8, 8G, DDR4, R)

Жесткий диск: Dell 1TB 7.2K RPM NLSAS 12Gbps 2.5in Hot-plug Drive – 2шт.

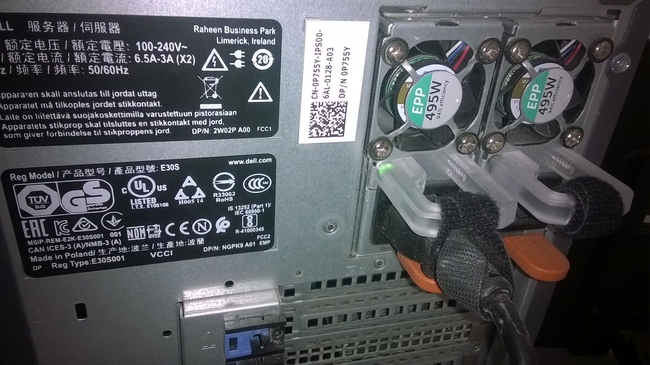

БП: Dell Hot Plug Redundant Power Supply 495W – 2шт.

ИБП: Powercom Macan MAS-2000

Чтоб узнать какая мат.плата в сервере можно посмотреть в BIOS, либо в ОС Windows воспользоваться командной строкой и командой wmic baseboard get product

HDD с возможностью горячей замены.

Блоки питания тоже с возможностью горячей замены, модульные, резервируют друг друга.

О своем сервере можно узнать по сервис тэгу. Подробная информация на сайте производителя.

Чтоб сберечь такой дорогой сервер от скачков и отключений напряжения необходимо подключать его в сеть электропитания через источник бесперебойного питания ON-LINE типа.

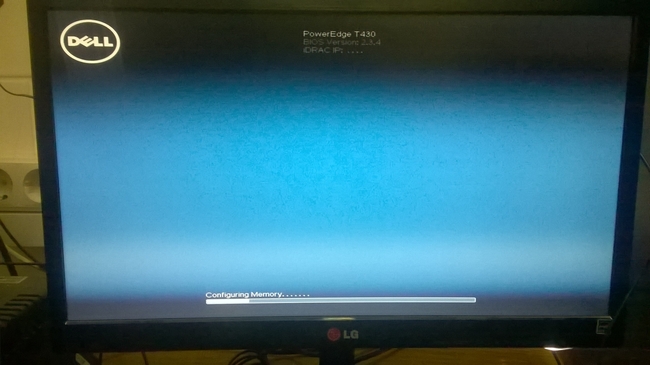

Подключаем питание, провод ЛВС, включаем ИБП, запускаем сервер.

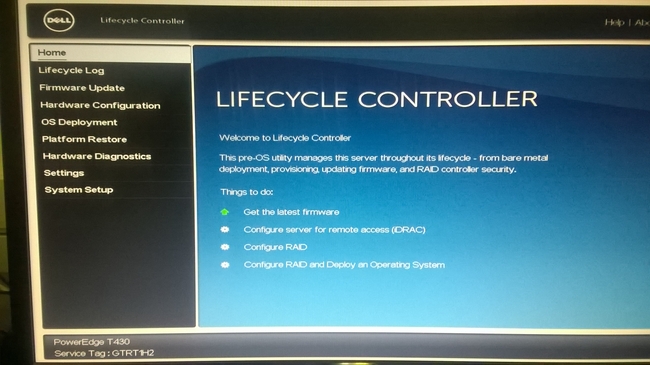

Ждем загрузку. Жмем F10 чтоб попасть в LifeCycle Controller.

Настроим RAID. Нажимаем в главном меню LifeCycle Controller >> Configure RAID.

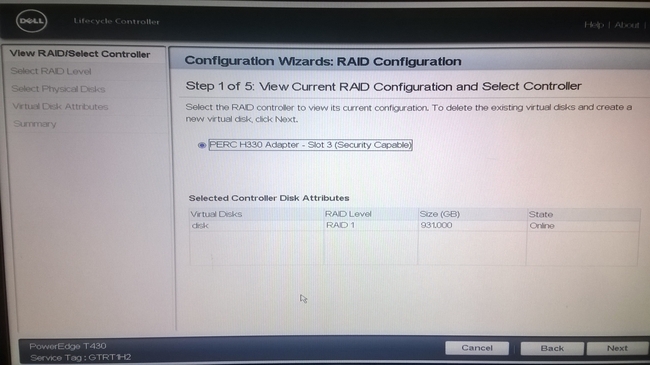

Откроется мастер настройки RAID. На первом шаге видим, что в сервере присутствует контроллер для создания RAID – PERC H330 Integrated RAID Controller. (чуть ниже видно что RAID уже создан, но пройдем по мастеру еще раз) Подробности об контроллере можно прочитать в мануале производителя. Жмем >>Next.

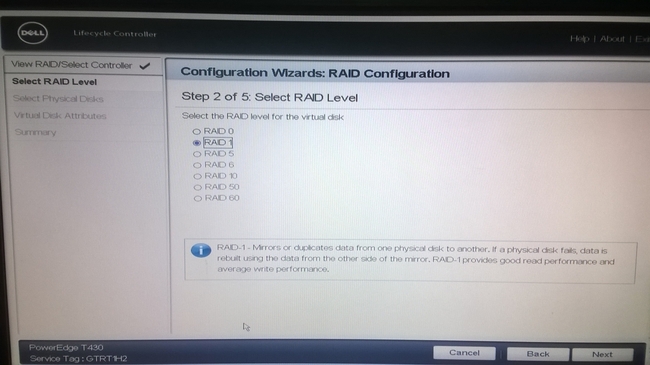

У нас как обычно сэкономили и в комплектации всего два HDD, по этому доступен RAID0 или RAID1. Для надежности системы будем делать RAID1 – зеркалировать один диск на другой. Наилучшим вариантом является RAID10, но для его создания необходимо минимум 4 HDD.

Выбираем RAID1 и жмем >>Next.

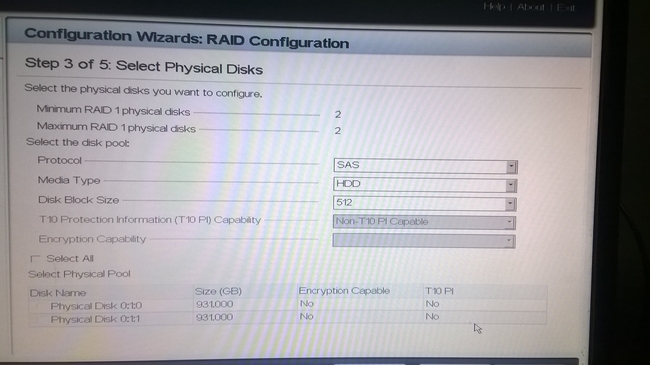

Выбираем два наших физических диска и жмем >>Next.

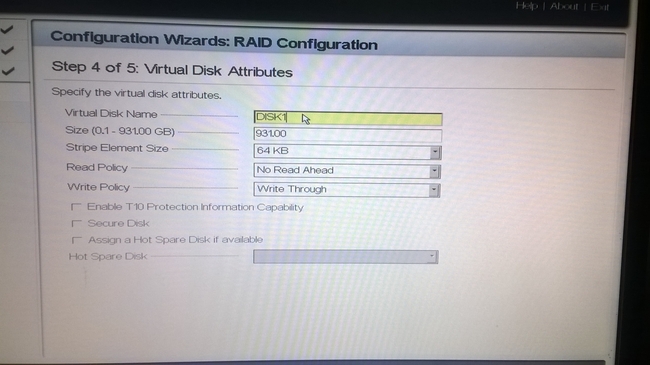

Настройки дисков решено было не менять. Можно написать название будущего RAID массива. >>Next.

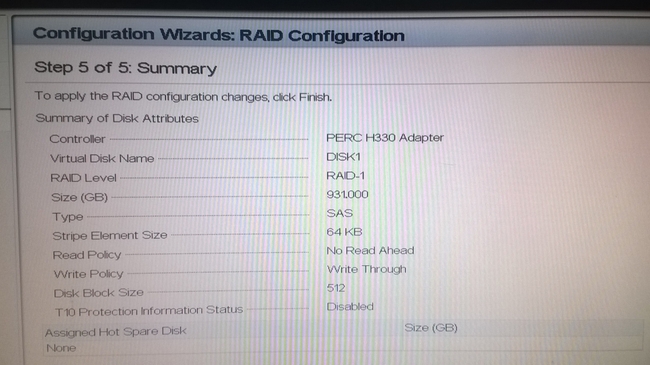

Последним шагом проверяем конфигурацию и жмем >>Finish.

Подтверждаем создание и через некоторое время RAID1 готов.

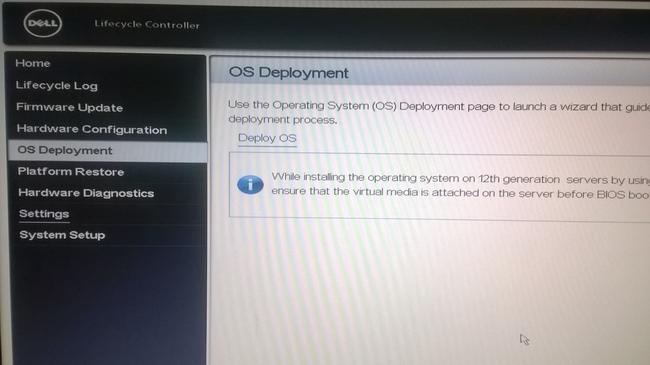

Переходим к установке ОС. На сайте тех поддержки DELL установка ОС через LifeCycle Controller называется предпочтительным методом.

Однако, в OS Deployment при нажатии на Deploy OS (развернуть ОС) система ругалась на отсутствия источника для установки ОС. По этому воспользуемся другим методом.

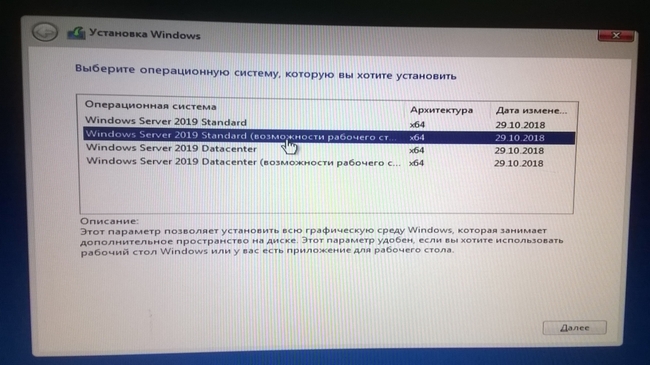

Изготавливаем загрузочную флэшку с Windows Server 2019. Флэшка должна подходить под тип UEFI с разметкой диска GPT. Если флэшку делать в RUFUS, то нужно выбирать именно такие настройки.

Вставляем флэшку в разъем USB сервера. На передней панели их два, можно в любой.

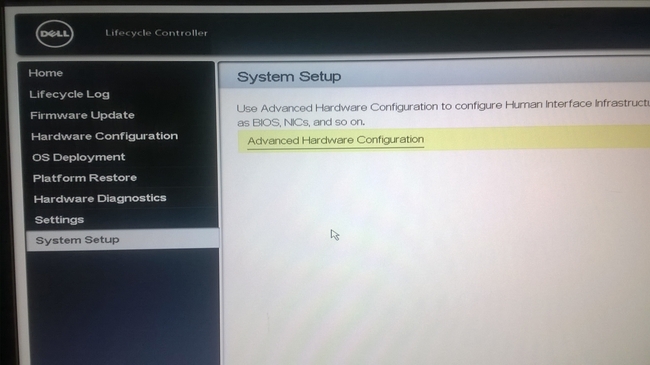

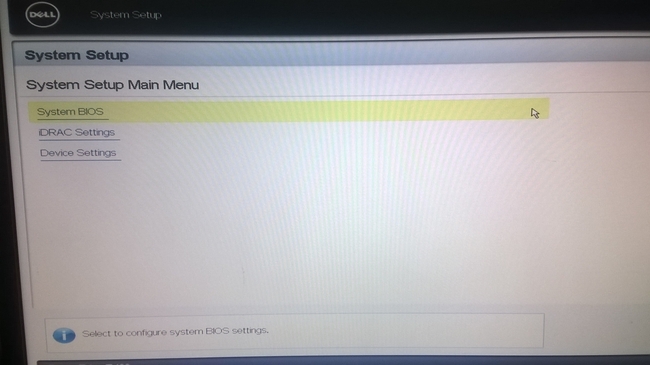

Запускаем сервер. Заходим в LifeCycle Controller нажимая F10. Переходим в пункт меню SystemSetup. Далее в Advanced Hardware Configuration.

Выбираем System BIOS.

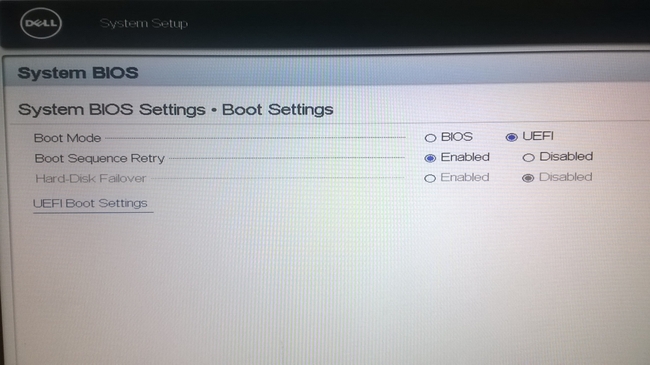

В BIOS отмечаем режим загрузки Boot Mode — UEFI.

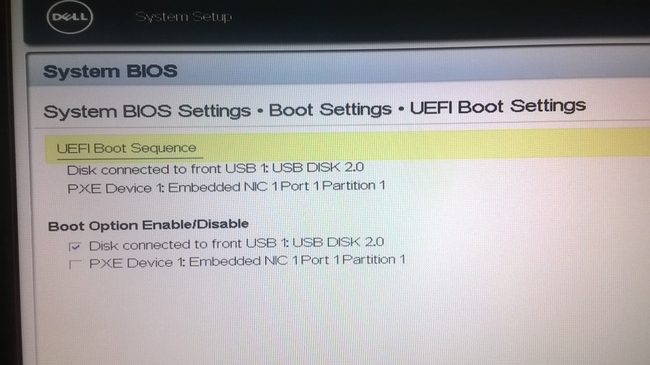

В пункте меню UEFI Boot Sequence отмечаем галочкой нашу флэшку – Disk connected to front USB1: USB DISK 2.0 (или в USB2, испробовано в обоих)

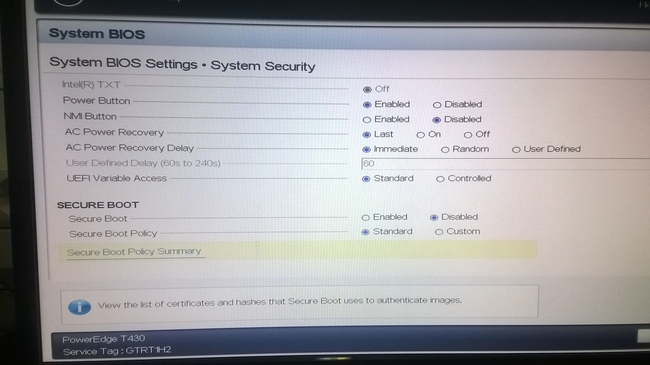

В пункте меню безопасность проверяем Secure Boot – Disabled.

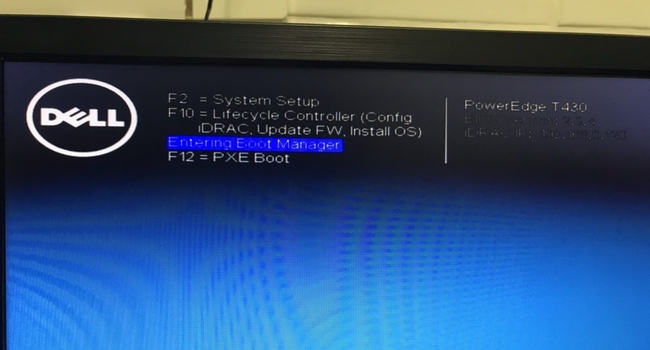

Сохраняем настройки, перезагружаем сервер. После перезагрузки жмем F11, чтоб попасть в Boot Manager.

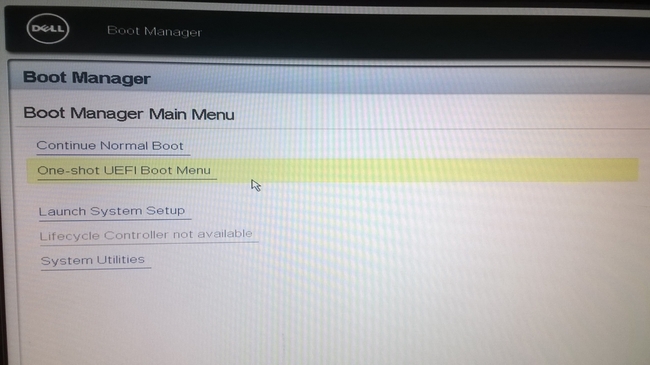

Выбираем One-Shot UEFI Boot Menu.

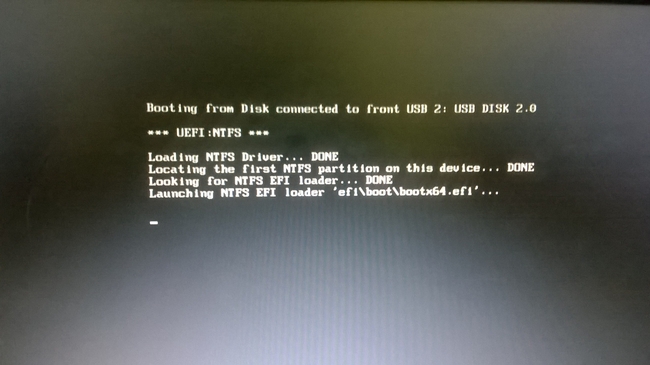

Начнется загрузка с флэшки.

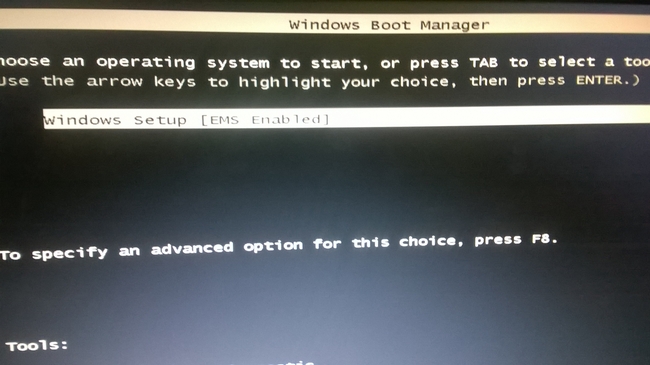

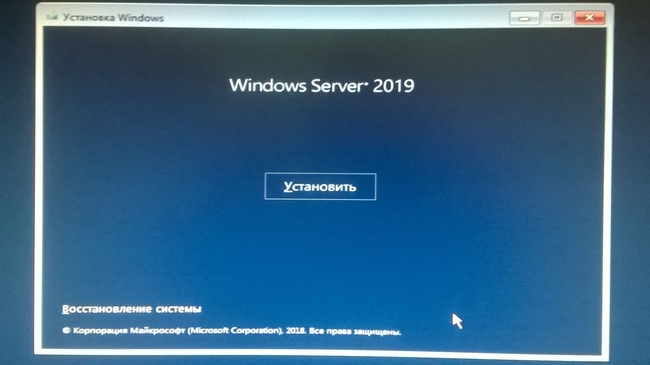

Пойдет установка ОС.

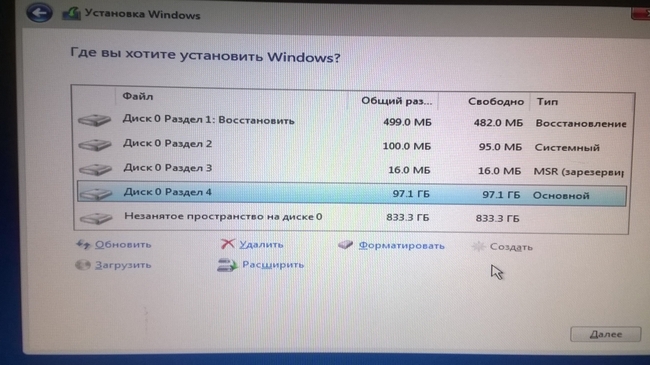

Размечаем единственный диск (который RAID1), 100Гб для системы, остальное для данных. Так же система создаст несколько дополнительных служебных разделов. Выбираем диск для установки системы и ждем, пока установка завершится.

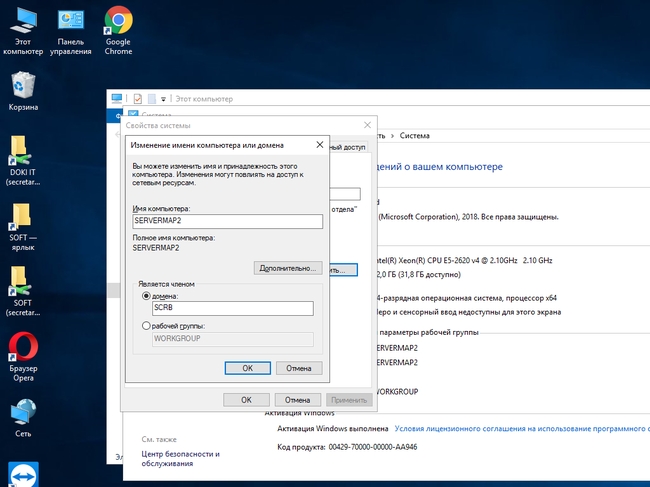

ОС Windows Server 2019 установлена. Назначаем IP-адрес, переименовываем сервер, размечаем диск, если требуется.

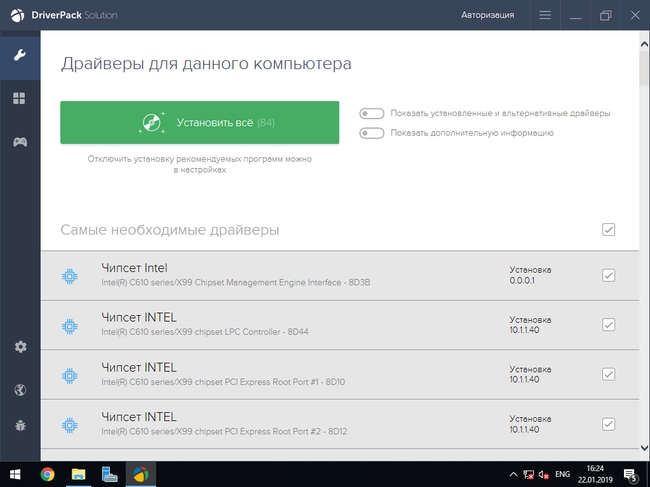

Обновляем драйверы оборудования. DriverPack определил 84 необходимых драйвера.

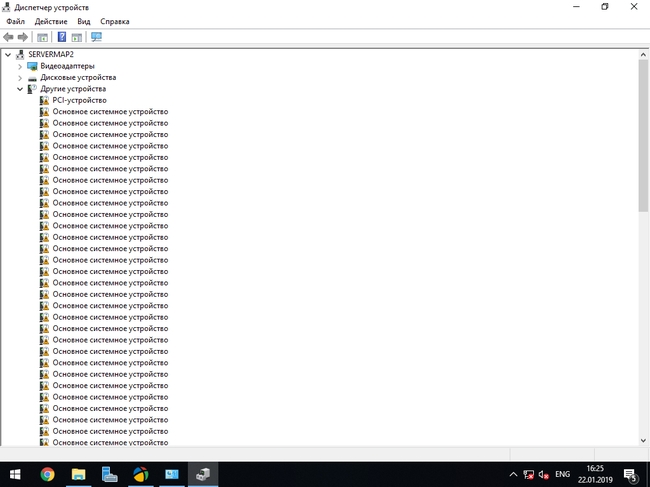

В диспетчере устройств действительно оказалось очень много не определившихся устройств.

Разрешаем RDP, добавляем сервер в домен.

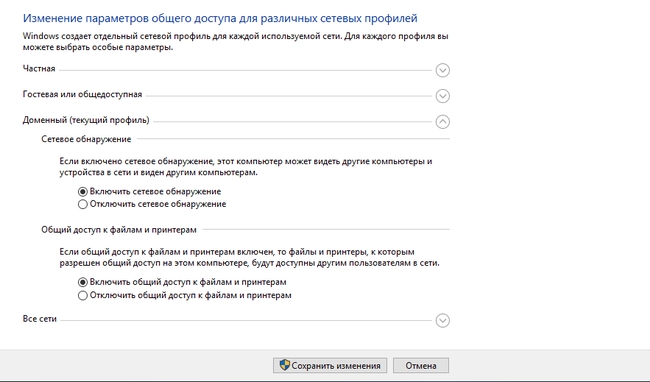

В процессе настроек обнаружилась проблема с включением сетевого обнаружения. После сохранения параметров сетевое обнаружение оказывается выключенным.

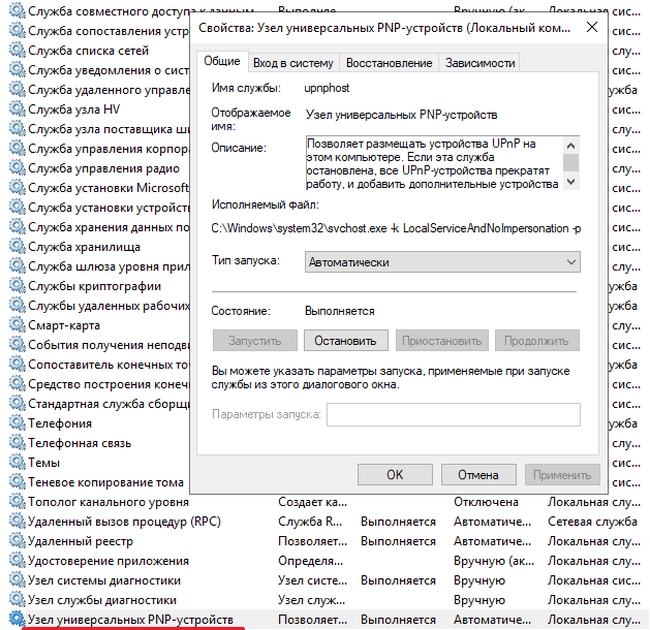

Для того, чтоб включить сетевое обнаружение, необходимо перейти в раздел Службы и активировать Узел универсальных PNP-устройств. Устанавливаем тип запуска – автоматически, нажимаем запустить, применить.

Так же необходимо убедится, что включены службы:

-Публикация ресурсов обнаружения функций.

После активации служб сетевое обнаружение включилось. Сервер обнаружился в сети.

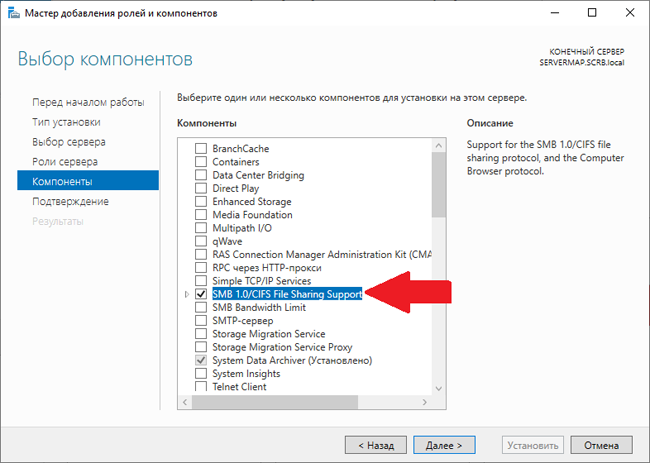

Еще одна определившаяся после запуска сервера проблема – отсутствие доступа к общим сетевым ресурсам сервера для пользователей с ОС Windows XP. У нас в сети ПК с подобной системой еще предостаточно. Решается проблема активацией дополнительного компонента SMB 1.0/CIFS File Sharing Support.

Следует учитывать, что установка компонента потребует перезагрузки сервера, поэтому его желательно активировать до ввода сервера в работу. Активация протокола SMB1 снижает безопасность системы, т.к. в нем присутствует большое количество критических уязвимостей, способствующих проникновению вредоносных программ.

Когда система настроена и работает как требуется, делаем её резервную копию.

Создание виртуальной машины в Hyper-V Windows Server 2012 R2

Создание виртуальной машины в Hyper-V Windows Server 2012 R2

Не так давно на страницах проекта gotoADM.ru была опубликована статья, а который был рассмотрен процесс установки сервера виртуализации Hyper-V на Windows Server 2012 R2. Сейчас мы продолжим развитие данной темы и выполним базовую настройки сервера Hyper-V, создадим виртуальный коммутатор, а затем виртуальную машину. Статья рассчитана на «самых молодых» ИТ специалистов и продолжает логическое и плавное развитие темы виртуализации и знакомство с гипервизором компании Microsoft.

Т.к. нашей виртуальной машине, да и всему парку VM необходимо активно работать с сетью, то перед созданием самой виртуальный машины я предлагаю выполнить настройки виртуального коммутатора. Стоит сразу отметить — для этого потребуется дополнительная сетевая карта. Существует три варианта работы виртуального коммутатора:

- Внешняя сеть — осуществляет связь между VM и физической сетью (как раз для этого и требуется отдельная сетевая карта)

- Внутренняя сеть — осуществляет связь только с VM и хостом виртуализации (т.е. сервером, где установлен гипервизор)

- Частная сеть — работа сети доступна только для виртуальных машин.

Как было сказано выше — нам подходит первый вариант, т.к. будет происходить активное использование сети.

В диспетчере управления гипервизором Hyper-V переходим в диспетчер виртуальных коммутаторов, как показано на рисунке выше. Далее выбираем нужный нам тип работы сети, указываем имя подключение (в нашем случае vSwith0) и сетевую карту, с которой необходимо связать работу VM. Теперь перейдем к созданию виртуальной машины. Сам процесс не сложен, «мастер» сделан просто и с достаточным уровнем подсказок и описаний:

В нашем случае диски и конфигурация виртуальных машин находится на том же сервере, если вы используете СХД или другое устройство — укажите корректный путь для расположения файлов жестких дисков.

В большинстве случаев необходимо выбирать второе поколение VM, но т.к. данная виртуальная машина создается под ОС Linux (CentOS 6.5 64bit), то для корректной работы данной операционной системы необходимо использовать первое поколение VM.

Указываем размер оперативной памяти, которая будет выделяться нашей будущей ОС. Стоит отметить — если разрабатываемый сервис будет малозагруженным или же нагрузка будет колебаться, то для более корректного использования ресурсов сервера виртуализации рекомендуется использовать динамическое выделение RAM.

Указываем сетевой адаптер — он позволит, как я уже говорил, работать с внешней сетью.

Еще раз проверяем настройки будущей системы — имя, расположение файла жесткого диска и указываем размер HDD.

И напоследок — указываем источник установки. В нашем случае — это iso образ, расположенный там же, где и сам гипервизор. После нажатия кнопки «далее» будет произведено создание VM. Запуск, выключение и настройка дополнительных параметров доступно также в диспетчере управления Hyper-V:

Настройка сети в Hyper-V и создание виртуальной машины завершено.

Нашли ошибку в тексте? Выделите фрагмент текста и нажмите Ctrl+Enter

VDS, VDI, кого хочешь выбирай: виртуализация десктопов глазами Dell

С приходом облачных технологий утопичная идея «иметь доступ к чему угодно, откуда угодно, с чего угодно» стала постепенно воплощаться в реальность. Всего за несколько лет понятия «частное облако», VDS, VDI и т.п. стали массово употребимыми – не без участия маркетологов практически всех крупных международных вендоров. Тем не менее, до сих пор существует определенная путаница терминов и понятий на рынке, а также ряд «неустаревающих» вопросов. Например, что такое виртуализация десктопов? Это технология или подход? В чем отличие виртуализации десктопов от инфраструктуры виртуальных рабочих столов? Наконец, при чем здесь Dell? За ответами на эти и другие вопросы просим под кат.

По порядку

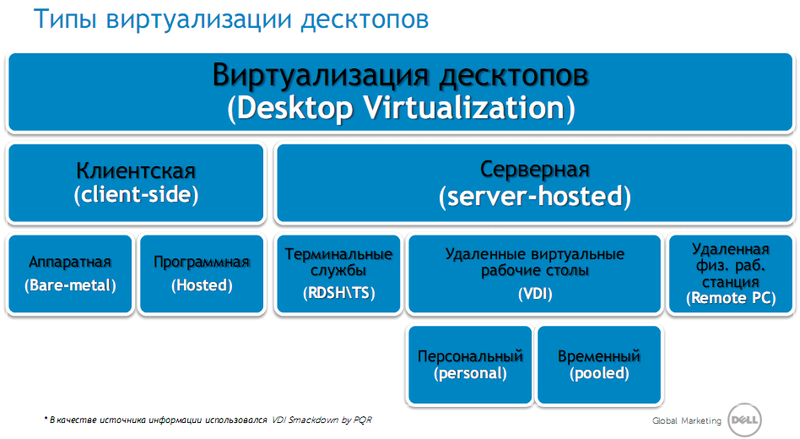

Виртуализация десктопов или виртуализация рабочих столов – это подход, при котором происходит разделение рабочей среды пользователя (ОС, приложения, данные) и физического устройства, на котором он привык работать (ПК, ноутбук). Благодаря данному подходу сотрудник больше не привязан к физическому рабочему месту в офисе, а может работать с привычными приложениями и данными с любого устройства (планшет, смартфон, тонкий клиент и т.д.) из любого места (дома, в дороге, из гостиницы или из интернет-кафе).

В основе этого подхода лежит не одна конкретная технология, а совместное использование различных технологических решений в области клиентской виртуализации. Наиболее популярными из них сегодня являются:

1. Инфраструктура виртуальных рабочих столов (VDI) – решение, позволяющее запустить ОС пользователя (Windows 7 и т.д.) внутри виртуальной машины на сервере в ЦОД и работать с ней удаленно с любого устройства (Citrix XenDesktop, VMware View, Microsoft VDI, Quest vWorkspace).

2. Службы удаленных рабочих столов или терминальные сервисы (Remote Desktop Services Host (RDSH)\Terminal Services (TS)) – классический терминальный доступ, предоставляющий серверную операционную систему (обычно, Windows Server 2008 R2 или 2012) нескольким пользователям в конкурентном режиме (кто первый встал, того и тапки). Каждый из удаленных пользователей работает в своей сессии. Наиболее популярные решения – Citrix XenApp, Microsoft RDS, Quest vWorkspace.

3. Удаленная физическая рабочая станция (Blade PC) – мощная высокопроизводительная рабочая станция (часто с установленным графическим адаптером) в форм-факторе сервера, расположенная в ЦОД, и предоставляющая свои вычислительные ресурсы удаленным пользователям. Наиболее популярные решения – Citrix HDX 3D Pro + Dell R5500, VMware View + Dell R5500.

4. Виртуализация приложений (Application Virtualization) – доставка и выполнение приложений на виртуальных машинах, терминальный сервер или ПК без привычной установки программы в ОС. Наиболее популярные решения: Microsoft App-V, Citrix XenApp, VMware ThinApp.

Здесь перечислены основные типы использующихся на данный момент технологий, однако ИТ, как известно, не стоит на месте и, возможно, уже завтра появится новый вариант виртуализации декстопов.

Реалии же сегодняшнего дня таковы: нельзя забывать, что при подобном подходе привычные персональные компьютеры пользователей могут и будут подвергнуты изменениям. Если раньше от компьютера требовалось наличие достаточных вычислительные мощностей для работы бизнес-приложений, а также большое дисковое пространство для хранения пользовательских данных, то теперь, когда процессы происходят в виртуальном пространстве ЦОДов, в этом просто пропала необходимость.

Будем считать, что с терминологией мы разобрались. Поэтому перейдём к более интересному вопросу.

Зачем?

Наверное, это второй в мире по популярности вопрос после детско-физического (любят задавать и дети, и физики) «почему». Зачем виртуализировать десктопы? Первопричина проста: конечно же, чтобы сэкономить. Давайте примерно прикинем выгоду от перехода с традиционных ПК к тонким клиентам. Конечно, кто-то скажет, что не всё можно решить с помощью ТК. Но это не совсем так: само устройство ТК практически универсально. Поэтому корректнее ставить вопрос следующим образом: «Какие наиболее выигрышные (или успешные) сценарии применения VDI существуют на данный момент?». А вот и они:

1. Модернизация инфраструктуры или создание новой

a. Выход из строя\устаревание техники

b. Открытие новых офисов, филиалов

2. Обеспечение безопасности и соответствие регламентам

a. Соответствие сертификационным требованиям

b. Сохранность и предотвращение утечек данных

3. Временные сотрудники и «сотрудники одной задачи»

a. Временные работы (проекты, аудит, контракт)

b. Сотрудники с узким кругом фиксированных обязанностей (call-center и т.д.)

4. Обучение и разработка

a. Учебные классы

b. Разработка приложений, тестирование и т.д.

Лично мне даже доказывать не надо выгоду от использования виртуализации десктопов в учебных классах. Так сказать, еще не канули в небытие воспоминания от университетских лабораторных работ, когда каждый должен был создать себе отдельную папку и надеяться, что предыдущая группа оставила систему во вменяемом состоянии. Ну да ладно, вернемся к нашим баранам вопросам финансовым.

1. Самая очевидная статья расходов, с которой мы сталкиваемся ежемесячно – энергопотребление. ТК в сравнении с ПК — это экономия не только пространства, но и энергии. Тонкий клиент потребляет в районе 7-15 ВТ (в зависимости от модели) против порядка 100 ВТ в случае традиционного ПК. И если мы хотим сравнить суммарные затраты за месяц, умножим на количество рабочих часов (8 часов на 5 дней на 4 недели = 160).

2. Надежность. Наличие большого количества подвижных частей в ПК, как известно, может привести к сбоям и, как следствие, постоянным простоям в работе сотрудников. Тут работает принцип «мы сильны настолько, насколько сильно наше самое слабое звено».

3. Поддержка и сопровождение – поддержка большого парка ПК приводит к существенным затратам для ИТ.

4. Устаревание – средний срок жизни ПК — 2-3 года с учетом постоянного роста потребностей со стороны приложений. Забегая вперед, скажем, что в реально крупных проектах по виртуализации рабочих столов (когда счёт идёт на тысячи мест), окупаемость как раз и начинается на третьем году.

Всё это приводит к росту популярности VDI (включая переход на ТК) в следующих индустриях:

Телеком:

• Мобильные сотрудники

• Развертывание временных инфраструктур (выборы, телемосты и т.д.)

Образование:

• Учебные классы

• Дистанционное обучение

• Электронные библиотеки

Банки и финансовые институты:

• Отделения банка, удаленные офисы

• Call-центры

Ритейл:

• Открытие торговых точек

• Кассиры

Что ж, настало время, перейти к завершающей стадии статьи и ответить на центральный вопрос.

При чем здесь Dell?

Компания Dell традиционно была известна обществу как исключительно «железячная» компания. Не будем спорить, когда-то так и было. Но времена изменились, и вместе с ними изменился подход Dell. За последний год компания объявила о двух крупных приобретениях, значимость которых для ИТ-рынка, а особенно для рынка виртуализации десктопов, сложно переоценить. Речь идет о компаниях Wyse и Quest Software.

Компания Wyse (теперь Dell Wyse) является мировым лидером в области токнких клиентов (ТК). В портфолио компании более 150 различных моделей ТК (всё-таки с 1981 года работают), отвечающих различным требованиям по работе с виртуальной инфраструктурой. ТК компании Dell Wyse сертифицированы для работы со всеми основными протоколами удаленного доступа (ICA\HDX, RDP, PCoIP), а также используют различные ОС в качестве локальной системы на ТК (Wyse ThinOS, Windows Embedded Standard, Linux). Помимо аппаратных решений, компания предоставляет программные решения по настройке, обновлению и управлению тонкими клиентами — Wyse Device Manager. На данный момент, решение существует в двух исполнениях:

• Dell Wyse Device Manager – устанавливаемое локально в вашей инфраструктуре программное обеспечение, имеющее серверную и агентскую составляющую.

• Dell Wyse Cloud Client Manager – облачный сервис от Dell, позволяющий управлять не только тонкими клиентами, но и мобильными устройствами на базе платформ iOS и Android.

Компания Quest Software является производителем программных решений в области управления ИТ. На текущий момент в портфолио компании входят 6 основных направлений:

• Управление базами данных (Database Management)

• Защита данных (Data Protection)

• Мониторинг производительности (Performance Monitoring)

• Управление виртуальными десктопами (User Workspace Management)

• Управление Windows серверами (Windows Server Management)

• Управление безопасностью (Identity&Access Management)

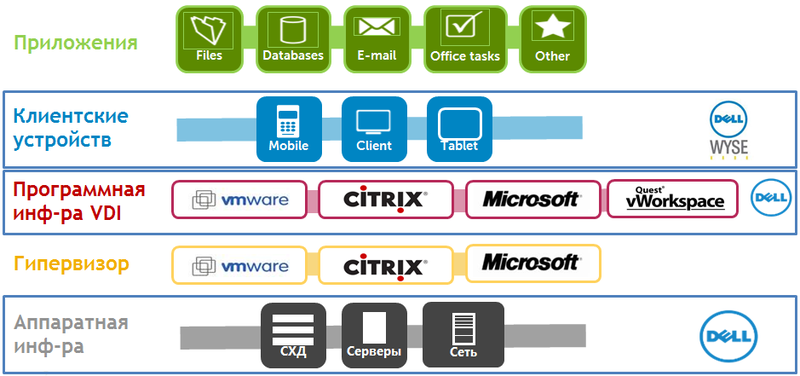

Таким образом, типовое решение для виртуализации рабочих столов можно представить в виде «VDI-пирога».

• Аппаратная инфраструктура – фундаментом решения являются серверы, использующиеся в качестве хостов виртуализации, на которых будут располагаться либо виртуальные машины, либо терминальные серверы для доступа к ним пользователей, системы хранения данных – для хранения дисков виртуальных машин и пользовательских данных, а также сетевая инфраструктура для обеспечения быстрой связи всех компонент.

• Платформа виртуализации – в качестве платформы виртуализации, гипервизора, Dell, являясь партнером всех лидеров этого рынка, (Microsoft, VMware, Citrix), предлагает вам самим определить, какая технология ближе. Также не нужно забывать про то, что у всех вышеперечисленных производителей гипервизоров есть бесплатные редакции, обладающие достаточно обширным функционалом.

• Программная инфраструктура VDI\TS — на этом уровне, помимо всех вышеперечисленных производителей виртуальных решений, Dell готов предложить конкурентноспособный вариант в виде Dell Virtualization (в прошлом Quest vWorkspace — www.quest.com/desktop-virtualization), представляющий собой диспетчер соединений между пользователем и запрашиваемым ресурсом, протокол оптимизации Experience Optimized Protocol (EOP), а также поддержку большинства мобильных платформ (Android, iOS). В качестве гипервизора, данное решение поддерживает Microsoft Hyper-V, Vmware ESX и Parallels Virtuozzo Containers.

• Клиентские устройства – в качестве конечных устройств могут использоваться практически любые устройства (ПК, планшеты, смартфоны и т.д.), но наиболее экономически выгодным вариантом на текущий момент является замена традиционных ПК на тонкие клиенты. Тонкие клиенты Dell Wyse поддерживают практически все известные на рынке инфраструктуры виртуализации десктопов (Microsoft, VMware, Citrix, Quest, Redhat), а так же возможность централизованного управления с помощью ПО Wyse Device Manager или Dell Cloud Client Manager. Под поддержкой подразумевается наличие соответствующего протокола на стороне ТК (RDP, ICA\HDX, PCoIP (как программную, так и аппаратную реализацию), EOP, SPICE).

• Приложения — в качестве технологии виртуализации приложений можно использовать любые из существующих решений, такие как Microsoft App-V или VMware ThinApp.

Но не отдельными компонентными решениями полнится портфель Dell. Есть что сказать и по поводу комплексности. Правда, мы рискуем увеличить объем статьи еще в два раза, если будем вдаваться в подробности. Поэтому, если коротенько и по делу.

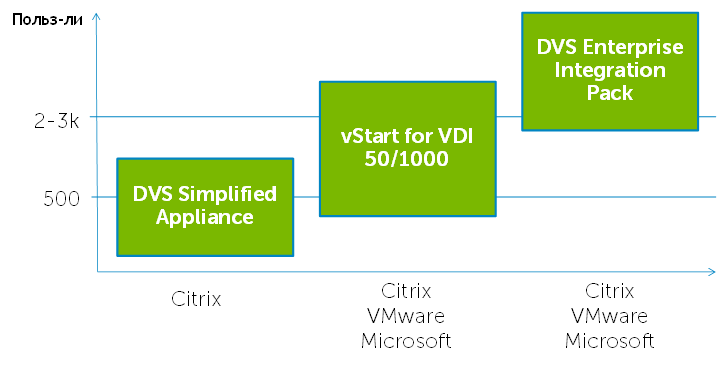

На текущий момент, в линейке решений для виртуализации десктопов от компании Dell присутствую следующие варианты:

1. DVS Simplified Appliance

2. vStart for VDI

3. DVS Integrated Solution Stack

Каждое из них ориентировано на различные размеры бизнеса и оптимизировано под различные задачи. В простейшем ранжировании (по количеству пользователей) их можно расположить следующим образом:

Подробнее о каждом из них мы еще напишем. А пока давайте завершим статью практическим примером виртуализации десктопов для задачи по 3D-моделированию.

Не откладывая в долгий ящик, знакомимся с логикой решения:

Представленная схема наглядно демонстрирует один из вариантов виртуализации. Проброс карты в виртуальную машину открывает новые горизонты для тех, кто использует XenApp инфраструктуру, т.к. вместо выделенного сервера можно использовать виртуальные машины, каждая из которых будет обладать своей выделенной графической картой. Это стало возможным благодаря появлению карт NVIDIA GRID K1 и K2, первым графическим адаптером для облачных вычислений. С точки зрения областей применения, серверное решение Dell PowerEdge R720 с картами GRID K1 и K2 позволяет создавать инфраструктуру с высокой плотностью, как обычных пользователей VDI, так и пользователей тяжёлых 3D приложений, т.е. покрывает полностью все выше перечисленные области виртуализации. В случае, когда серверное решение не является приемлемым, использование Dell Precision R5500 с NVIDIA Quadro так же открывает все возможности виртуализации.

Если у вас стоит задача перевести в виртуальную среду своих офисных пользователей, то самым оптимальным серверным решением будет Dell PowerEdge R720 c GRID K1. Благодаря тому, что карта обладает 4 графическими чипами на архитектуре Kepler и 16ГБ фреймбуффером (по 4ГБ на чип), обеспечивается высокая плотность людей на сервер. Так же высокой плотности можно добиться и для простых CAD приложений (AutoCAD, Kompas-3D и т.п.) разместив на сервере 1U сервере до 8 пользователей, благодаря механизму проброса карты в виртуальную машину.

Если у вас стоит задача перевести пользователей тяжёлых 3D приложений, то решение Dell PowerEdge с GRID K2 открывает вам возможности пересадить 4 инженеров на 1U сервер и при этом дать им возможность ощутить скорость работы сравнимую с обычной рабочей станцией.

Использование Dell Precision R5500 с NVIDIA Quadro откроет небольшим компаниям, не обладающим выделенными серверными помещениями, задействовать виртуализацию и ощутить её преимущества.

Вывод

Все чаще и чаще в СМИ встречается термин «Эпоха post-PC». В действительности же отказ от классического ПК не будет столь категоричен. По-прежнему остаются бизнес-задачи, которые сложно (или слишком затратно) решать с помощью ТК, используя виртуализацию десктопов (чего стоит только битва за IOPs). Однако стоит понимать, что с развитием технологий виртуализации появляется все больше и больше возможностей для сокращения затрат и оптимизации работы сотрудников посредствам использования более современных технологий.